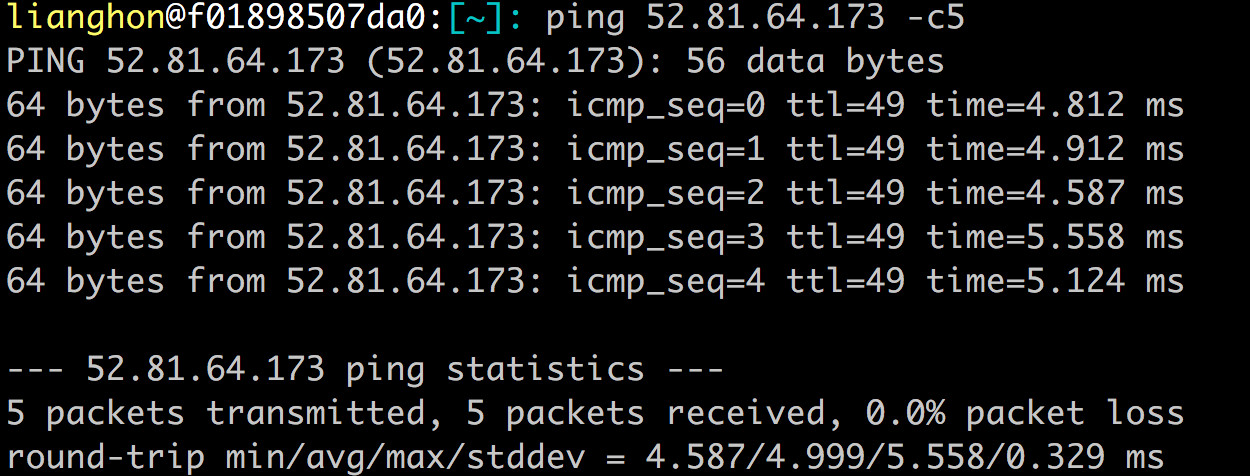

Constructing networks...

Setting up PyTorch plugin "bias_act_plugin"... Failed!

Traceback (most recent call last):

File "~/source/stylegan3/train.py", line 286, in <module>

main() # pylint: disable=no-value-for-parameter

File "~/anaconda3/envs/stylegan3/lib/python3.9/site-packages/click/core.py", line 1128, in __call__

return self.main(*args, **kwargs)

File "~/anaconda3/envs/stylegan3/lib/python3.9/site-packages/click/core.py", line 1053, in main

rv = self.invoke(ctx)

File "~/anaconda3/envs/stylegan3/lib/python3.9/site-packages/click/core.py", line 1395, in invoke

return ctx.invoke(self.callback, **ctx.params)

File "~/anaconda3/envs/stylegan3/lib/python3.9/site-packages/click/core.py", line 754, in invoke

return __callback(*args, **kwargs)

File "~/source/stylegan3/train.py", line 281, in main

launch_training(c=c, desc=desc, outdir=opts.outdir, dry_run=opts.dry_run)

File "~/source/stylegan3/train.py", line 96, in launch_training

subprocess_fn(rank=0, c=c, temp_dir=temp_dir)

File "~/source/stylegan3/train.py", line 47, in subprocess_fn

training_loop.training_loop(rank=rank, **c)

File "~/source/stylegan3/training/training_loop.py", line 168, in training_loop

img = misc.print_module_summary(G, [z, c])

File "~/source/stylegan3/torch_utils/misc.py", line 216, in print_module_summary

outputs = module(*inputs)

File "~/anaconda3/envs/stylegan3/lib/python3.9/site-packages/torch/nn/modules/module.py", line 1071, in _call_impl

result = forward_call(*input, **kwargs)

File "~/source/stylegan3/training/networks_stylegan3.py", line 511, in forward

ws = self.mapping(z, c, truncation_psi=truncation_psi, truncation_cutoff=truncation_cutoff, update_emas=update_emas)

File "~/anaconda3/envs/stylegan3/lib/python3.9/site-packages/torch/nn/modules/module.py", line 1071, in _call_impl

result = forward_call(*input, **kwargs)

File "~/source/stylegan3/training/networks_stylegan3.py", line 151, in forward

x = getattr(self, f'fc{idx}')(x)

File "~/anaconda3/envs/stylegan3/lib/python3.9/site-packages/torch/nn/modules/module.py", line 1071, in _call_impl

result = forward_call(*input, **kwargs)

File "~/source/stylegan3/training/networks_stylegan3.py", line 100, in forward

x = bias_act.bias_act(x, b, act=self.activation)

File "~/source/stylegan3/torch_utils/ops/bias_act.py", line 84, in bias_act

if impl == 'cuda' and x.device.type == 'cuda' and _init():

File "~/source/stylegan3/torch_utils/ops/bias_act.py", line 41, in _init

_plugin = custom_ops.get_plugin(

File "~/source/stylegan3/torch_utils/custom_ops.py", line 136, in get_plugin

torch.utils.cpp_extension.load(name=module_name, build_directory=cached_build_dir,

File "~/anaconda3/envs/stylegan3/lib/python3.9/site-packages/torch/utils/cpp_extension.py", line 1080, in load

return _jit_compile(

File "~/anaconda3/envs/stylegan3/lib/python3.9/site-packages/torch/utils/cpp_extension.py", line 1318, in _jit_compile

return _import_module_from_library(name, build_directory, is_python_module)

File "~/anaconda3/envs/stylegan3/lib/python3.9/site-packages/torch/utils/cpp_extension.py", line 1701, in _import_module_from_library

module = importlib.util.module_from_spec(spec)

File "<frozen importlib._bootstrap>", line 565, in module_from_spec

File "<frozen importlib._bootstrap_external>", line 1173, in create_module

File "<frozen importlib._bootstrap>", line 228, in _call_with_frames_removed

ImportError: ~/anaconda3/envs/stylegan3/lib/python3.9/site-packages/torch/lib/../../../../libstdc++.so.6: version `GLIBCXX_3.4.29' not found (required by ~/.cache/torch_extensions/bias_act_plugin/3cb576a0039689487cfba59279dd6d46-nvidia-geforce-rtx-3060/bias_act_plugin.so)