新建一个Flutter项目,在代码中不断添加控件,会使得页面的高度超过屏幕可以容纳的高度,此时并不会自动滚动,而是会出现错误提示超过屏幕高度(“BOTTOM OVERFLOWD BY xxx PIXELS”)。

Sqflite数据存储模型&无必要使用Isolate操作数据库

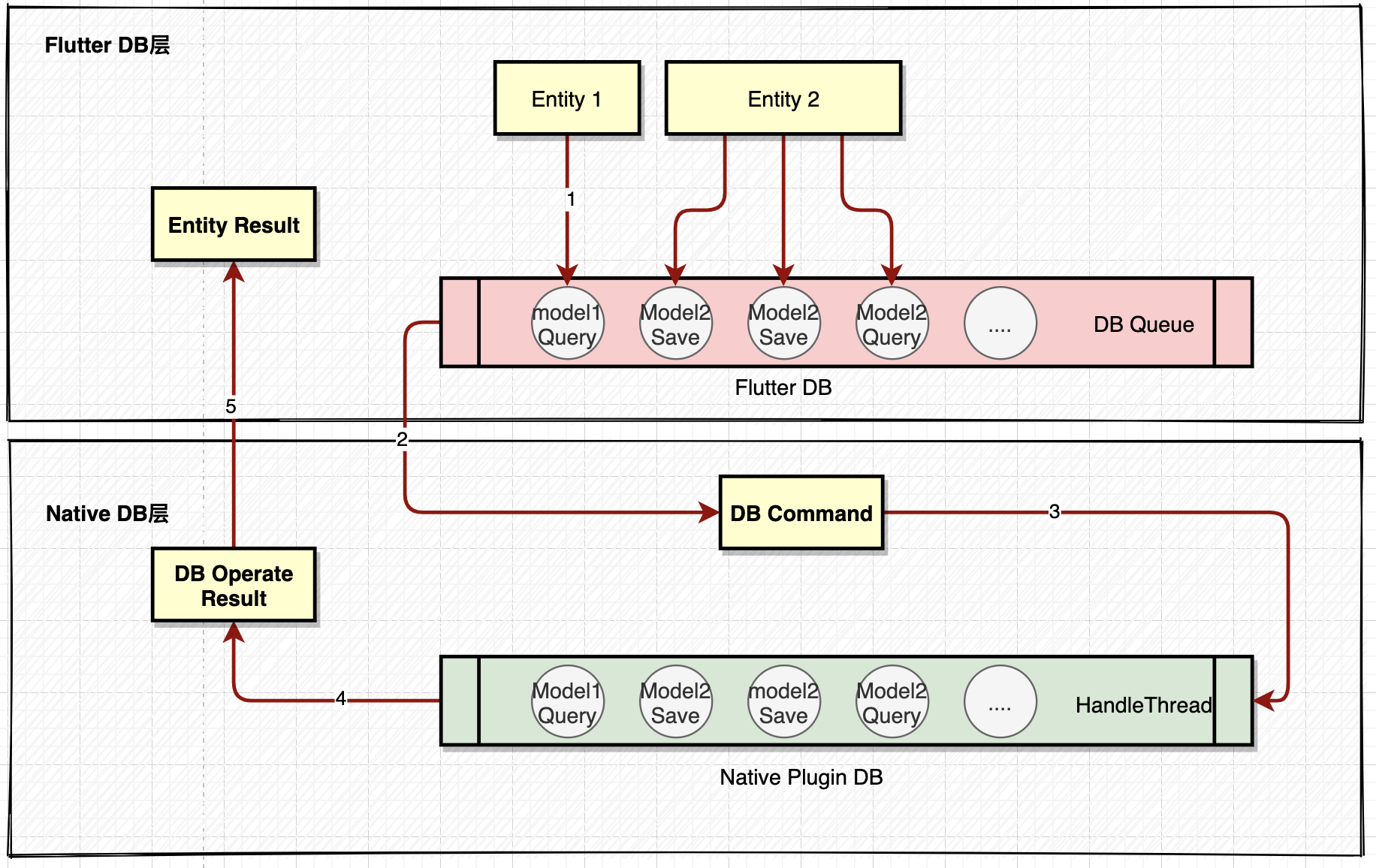

Sqflite存储模型如下:

依据上图Sqflite插件的DB存储模型会有2个等待队列,一个是Flutter层同步执行队列,一个是Native层的线程执行队列

其Android实现机制是HandlerThread,底层使用同一个静态变量,因此Query/Save读写在会同一线程队列中,不同数据库的操作也需要在同一个线程队列中排队。具体参考代码 SqflitePlugin.java

- 其iOS的实现是通过 dispatch_async(dispatch_get_global_queue(DISPATCH_QUEUE_PRIORITY_DEFAULT, 0),...),把任务调度到系统的后台线程排队顺序执行,原理类似于HandlerThread。只是这样会造成一个问题,如果其他功能也使用系统队列,会造成不必要的延迟。iOS定义一个数据库专用线程会更好一些。具体参考代码 SqflitePlugin.m

我们在系统层调用 Sqlite 的时候,需要注意 Sqlite 调用的耗时阻塞问题,一般都是在子线程中操作数据库,而由于 Sqflite 系统层后台线程队列的存在,在 Flutter 层,其实没必要使用 isolate 对耗时操作进行规避,这点与原生开发不同。

注意

如果确实需要在 isolate 中执行 Sqflite 相关的调用,一般建议使用 FlutterIsolate 创建 isolate ,主要原因还是 Sqlite 相关的调用都是 Platform Channel 的调用。默认情况下,在 isolate 是不允许调用这些函数的。

FlutterIsolate allows creation of an Isolate in flutter that is able to use flutter plugins. It creates the necessary platform specific bits (FlutterBackgroundView on android & FlutterEngine on iOS) to enable the platform channels to work inside an isolate.

参考链接

Dart语言构造函数中存在异步方法时的处理方法

dart语言构造函数中如果存在异步方法,编程时如果不注意特殊处理的话,很容易使代码出现未定义行为。例如下面的代码:

|

1 2 3 4 5 6 7 8 9 10 11 12 13 14 15 16 17 18 19 20 |

class MyComponent{ MyComponent() { init(); } init() async{ var ret = await _init(); print('$ret'); } _init(){ return Future.delayed(new Duration(seconds: 2), () { return "hello"; }); } } void main() { var c = new MyComponent(); print("done"); } |

本意是想先输出“hello“ 然后再输出”done",然而输出顺序刚好相反。原因在于init是异步方法,本应该在调用前使用await等待异步方法返回。然而在构造函数中是无法使用await的。那么该如何处理呢?下面是一种方法,使用工厂函数产生类的对象。而工厂函数是异步的,需要配合await使用。虽然能够解决异步构造的问题,但总觉得不够优雅。

|

1 2 3 4 5 6 7 8 9 10 11 12 13 14 15 16 17 18 19 20 21 22 23 24 25 26 27 28 29 30 31 32 33 34 35 36 37 38 |

import 'dart:async'; import 'dart:io'; class MyComponent{ /// Private constructor MyComponent._create() { print("_create() (private constructor)"); // Do most of your initialization here, that's what a constructor is for //... } _complexAsyncInit(){ return Future.delayed(new Duration(seconds: 2), () { return "hello"; }); } /// Public factory static Future<MyComponent> create() async { print("create() (public factory)"); // Call the private constructor var component = MyComponent._create(); // Do initialization that requires async var ret = await component._complexAsyncInit(); print("async return value: $ret"); // Return the fully initialized object return component; } } void main() async { var c = await MyComponent.create(); print("done"); } |

输出:

|

1 2 3 4 |

I/flutter (14941): create() (public factory) I/flutter (14941): _create() (private constructor) I/flutter (14941): async return value: hello I/flutter (14941): done |

参考链接

Flutter(able) 的单例模式

一个类只允许创建一个实例,那这个类就是一个单例类,这种设计模式就叫作单例设计模式,简称单例模式。

作为最简单的一种设计模式之一,对于单例本身的概念,大家一看就能明白,但在某些情况下也很容易使用不恰当。相比其他语言,Dart 和 Flutter 中的单例模式也不尽相同,本篇文章我们就一起探究看看它在 Dart 和 Flutter 中的应用。

Dart并发机制详解

Dart 通过 async-await、isolate 以及一些异步类型概念 (例如 Future 和 Stream) 支持了并发代码编程。本篇文章会对 async-await、Future 和 Stream

进行简略的介绍,而侧重点放在 isolate 的讲解上。

在应用中,所有的 Dart 代码都在 isolate 中运行。每一个 Dart 的 isolate 都有独立的运行线程,它们无法与其他 isolate 共享可变对象。在需要进行通信的场景里,isolate 会使用消息机制。尽管 Dart 的 isolate 模型设计是基于操作系统提供的进程和线程等更为底层的原语进行设计的,但在本篇文章中,我们不对其具体实现展开讨论。

大部分 Dart 应用只会使用一个 isolate (即 主 isolate),同时你也可以创建更多的 isolate,从而在多个处理器内核上达成并行执行代码的目的。

多平台使用时注意

所有的 Dart 应用都可以使用 async-await、

Future和Stream。

而 isolate 仅针对 原生平台的使用 进行实现。

使用 Dart 构建的网页应用可以 使用 Web Workers 实现相似的功能。

McCabe度量法

McCabe概念

McCabe度量法是一种基于程序控制流的复杂性度量方法。

McCabe复杂性度量又称环路度量,其计算公式为: V(G)=M-N+2,其中M和N分别代表图中的边数和顶点数。

Widget的物理模拟动画效果

物理模拟能够让应用富有真实感和更好的交互性。例如,你可能会为一个 widget 添加动画,让它看起来就像安着弹簧,或是在随重力下落。

这个指南演示了如何将 widget 从拖动的点移回到中心,并使用弹簧模拟效果。

这个演示将进行下面几步:

- 创建一个动画控制器

- 使用手势移动 widget

- 对 widget 进行动画

- 计算速度以模拟弹跳运动

Flutter手势交互 ( 跟随手指运动的小球 )

Flutter 手势 - 跟随手指运动的小球

设置小球坐标变量 : 其中 currentX 是距离左侧边界的距离 , currentY 是距离右侧边界的距离 ;

|

1 2 3 4 |

/// 当前小球的 x 坐标 double currentX = 0; /// 当前小球的 y 坐标 double currentY = 0; |

小球的位置 : 小球是在 Stack 帧布局中的 Positioned 组件 , 其 left 和 top 字段值设置其坐标 , 分别对应 currentX 和 currentY 值 ;

|

1 2 3 4 5 6 |

// 小球 Positioned( /// 当前位置 left: currentX, top: currentY, ) |

监听事件 : 监听 GestureDetector 组件的 onPanUpdate 事件 , 其回调方法是 void Function(DragUpdateDetails details) 类型的 方法 , 可以从 DragUpdateDetails 类型参数中获取当前 x , y 的移动距离 , 该距离需要与之前的距离累加 , 才能得到准确的坐标值 ;

在回调方法中调用 setState 方法 , 修改成员变量 currentX 和 currentY , 从而修改 Positioned 组件的位置 , 以达到小球移动的目的 ;

|

1 2 3 4 5 6 7 8 9 10 11 |

/// 手势检测组件 child: GestureDetector( /// 移动操作 onPanUpdate: (e){ setState(() { // e 中只能获取到 delta 值 , 需要逐步累加 currentX += e.delta.dx; currentY += e.delta.dy; }); }, ) |

代码示例 :

|

1 2 3 4 5 6 7 8 9 10 11 12 13 14 15 16 17 18 19 20 21 22 23 24 25 |

// 小球 Positioned( /// 当前位置 left: currentX, top: currentY, /// 手势检测组件 child: GestureDetector( /// 移动操作 onPanUpdate: (e){ setState(() { // e 中只能获取到 delta 值 , 需要逐步累加 currentX += e.delta.dx; currentY += e.delta.dy; }); }, // 黑色小球 child: Container( width: 40, height: 40, decoration: BoxDecoration( color: Colors.black, borderRadius: BorderRadius.circular(20), ), ), ),), |

完整代码示例

完整代码示例 :

|

1 2 3 4 5 6 7 8 9 10 11 12 13 14 15 16 17 18 19 20 21 22 23 24 25 26 27 28 29 30 31 32 33 34 35 36 37 38 39 40 41 42 43 44 45 46 47 48 49 50 51 52 53 54 55 56 57 58 59 60 61 62 63 64 65 66 67 68 69 70 71 72 73 74 75 76 77 78 79 80 81 82 83 84 85 86 87 88 89 90 91 92 93 94 95 96 97 98 99 100 101 102 103 104 105 106 107 108 109 110 111 112 113 114 115 116 117 118 119 120 121 122 123 124 125 126 127 128 129 130 131 132 133 134 135 136 137 138 139 140 141 142 143 144 145 146 147 148 149 150 151 152 153 154 155 156 157 158 159 160 161 162 |

import 'package:flutter/foundation.dart'; import 'package:flutter/material.dart'; class GesturePage extends StatefulWidget { const GesturePage({Key? key}) : super(key: key); @override _GesturePageState createState() => _GesturePageState(); } class _GesturePageState extends State<GesturePage> { /// 当前小球的 x 坐标 double currentX = 0; /// 当前小球的 y 坐标 double currentY = 0; @override Widget build(BuildContext context) { return MaterialApp( // 设置主题 theme: ThemeData( primarySwatch: Colors.amber, ), // 设置主体组件 home: Scaffold( // 设置标题栏 appBar: AppBar( title: const Text("手势检测"), // 返回按钮设置 leading: GestureDetector( // 点击事件回调函数 onTap: () { // 退出当前界面 Navigator.pop(context); }, // 回退按钮图标 child: const Icon(Icons.arrow_back), ), ), // 水平/垂直方向平铺组件 body: FractionallySizedBox( // 水平方向平铺 widthFactor: 1, // 帧布局 child: Stack( children: <Widget>[ // 垂直方向线性布局 Column( children: <Widget>[ // 手势检测组件 GestureDetector( // 点击事件 onTap: () { if (kDebugMode) { print("双击"); } }, // 双击事件 onDoubleTap: () { if (kDebugMode) { print("双击"); } }, // 长按事件 , ()=>方法名(参数列表) 即可回调一个现有方法 onLongPress: () => _longPress(), // 点击取消 onTapCancel: () { if (kDebugMode) { print("点击取消"); } }, // 点击按下 onTapDown: (e) { if (kDebugMode) { print("点击按下"); } }, // 点击抬起 onTapUp: (e) { if (kDebugMode) { print("点击抬起"); } }, // 手势检测的作用组件 , 监听该组件上的各种手势 child: Container( // 子组件居中 alignment: Alignment.center, // 内边距 padding: const EdgeInsets.all(100), // 背景装饰 decoration: const BoxDecoration( color: Colors.green, ), child: const Text( "手势检测", style: TextStyle( fontSize: 50, color: Colors.red, ), ), ), ) ], ), // 小球 Positioned( /// 当前位置 left: currentX, top: currentY, /// 手势检测组件 child: GestureDetector( /// 移动操作 onPanUpdate: (e) { setState(() { // e 中只能获取到 delta 值 , 需要逐步累加 currentX += e.delta.dx; currentY += e.delta.dy; }); }, // 黑色小球 child: Container( width: 40, height: 40, decoration: BoxDecoration( color: Colors.black, borderRadius: BorderRadius.circular(20), ), ), ), ), ], ), ), ), ); } /// 长按事件 void _longPress() { if (kDebugMode) { print("长按"); } } } |

Windows git ssh报错“no matching host key type found. Their offer: ssh-rsa,ssh-dss”

Windows 下检出代码的时候报错:

|

1 2 3 4 5 6 7 |

$ git clone root@10.10.10.10:/nfs/MyCloud/.Git/xxxx Cloning into 'xxxx'... Unable to negotiate with 10.10.10.10 port 22: no matching host key type found. Their offer: ssh-rsa,ssh-dss fatal: Could not read from remote repository. Please make sure you have the correct access rights and the repository exists. |

解决:

前提: 在排除没有配置公钥的情况下。

- 在Git的安装目录下

Git > etc > ssh文件夹下找到ssh_config文件 - 在文件末尾添加一下代码(注意,这里的 xxx.com 就是远程仓库地址或者ip,格式如:baidu.com)

|

1 2 3 |

Host xxx.com HostkeyAlgorithms +ssh-rsa PubkeyAcceptedAlgorithms +ssh-rsa |

参考链接

windows git ssh 方式提示 no matching host key type found. Their offer: ssh-rsa,ssh-dss

Dart 2.15更新后isolate应该这么用

序言

2021年的最后一天, Dart 官方发布了 dart 2.15 版本,该版本优化了很多内容,今天我们要重点说说 isolate 工作器。官方推文链接

在探索新变化之前,我们来回忆巩固一下 isolate 的使用。

isolate 的作用

问题:Flutter 基于单线程模式使用协程进行开发,为什么还需要 isolate ?

首先我们要明确 并行(isolate) 与并发(future)的区别。下面我们通过简单的例子来进行说明 。Demo 是一个简单的页面,中间放置一个不断转圈的 progress 和一个按键,按键用来触发耗时方法。

|

1 2 3 4 5 6 7 8 9 10 11 |

///计算偶数个数(具体的耗时操作)下面示例代码中会用到 static int calculateEvenCount(int num) { int count = 0; while (num > 0) { if (num % 2 == 0) { count++; } num--; } return count; } |

|

1 2 3 4 5 |

///按键点击事件 onPressed: () { //触发耗时操作 doMockTimeConsume(); } |

- 方式一: 我们将耗时操作使用

future的方式进行封装

|

1 2 3 4 5 6 7 8 9 10 11 12 |

///使用future的方式封装耗时操作 static Future<int> futureCountEven(int num) async { var result = calculateEvenCount(num); return Future.value(result); } ///耗时事件 void doMockTimeConsume() async { var result = await futureCountEven(1000000000); _count = result; setState(() {}); } |

结论:使用 future 的方式来消费耗时操作,由于仍然是单线程在进行工作,异步只是在同一个线程的并发操作,仍会阻塞UI的刷新。

- 方式二: 使用

isolate创建新线程,避开主线程,不干扰UI刷新

|

1 2 3 4 5 6 |

//模拟耗时操作 void doMockTimeConsume() async { var result = await isolateCountEven(1000000000); _count = result; setState(() {}); } |

|

1 2 3 4 5 6 7 8 9 10 11 12 13 14 |

///使用isolate的方式封装耗时操作 static Future<dynamic> isolateCountEven(int num) async { final p = ReceivePort(); ///发送参数 await Isolate.spawn(_entryPoint, [p.sendPort, num]); return (await p.first) as int; } static void _entryPoint(SendPort port) { SendPort responsePort = args[0]; int num = args[1]; ///接收参数,进行耗时操作后返回数据 responsePort.send(calculateEvenCount(num)); } |

结论:使用 isolate 实现了多线程并行,在新线程中进行耗时操作不会干扰UI线程的刷新。

isolate 的局限性,为什么需要优化?

iso 有两点较为重要的局限性。

- isolate 消耗较重,除了创建耗时,每次创建还至少需要2Mb的空间,有OOM的风险。

- isolate 之间的内存空间各自独立,当参数或结果跨 iso 相互传递时需要深度拷贝,拷贝耗时,可能造成UI卡顿。

isolate 新特性

Dart 2.15 更新, 给 iso 添加了组的概念,isolate 组 工作特征可简单总结为以下两点:

- Isolate 组中的 isolate 共享各种内部数据结构

- Isolate 组

仍然阻止在 isolate 间共享访问可变对象,但由于 isolate 组使用共享堆实现,这也让其拥有了更多的功能。

官方推文中举了一个例子:

工作器 isolate 通过网络调用获得数据,将该数据解析为大型 JSON 对象图,然后将这个 JSON 图返回到主 isolate 中。

Dart 2.15 之前:执行该操作需要深度复制,如果复制花费的时间超过帧预算时间,就会导致界面卡顿。

使用 Dart 2.15:工作器 isolate 可以调用Isolate.exit(),将其结果作为参数传递。然后,Dart 运行时将包含结果的内存数据从工作器 isolate 传递到主 isolate 中,无需复制,且主 isolate 可以在固定时间内接收结果。

重点:提供 Isolate.exit() 方法,将包含结果的内存数据从工作器 isolate 传递到主 isolate,过程无需复制。

附注: 使用 Dart 新特性,需将 flutter sdk 升级到 2.8.0 以上 链接。

isolate中:exit 和 send 的区别及用法

Dart 更新后,我们将数据从 工作器 isolate(子线程)回传到 主 isolate(主线程)有两种方式。

- 方式一: 使用

send

|

1 |

responsePort.send(data); |

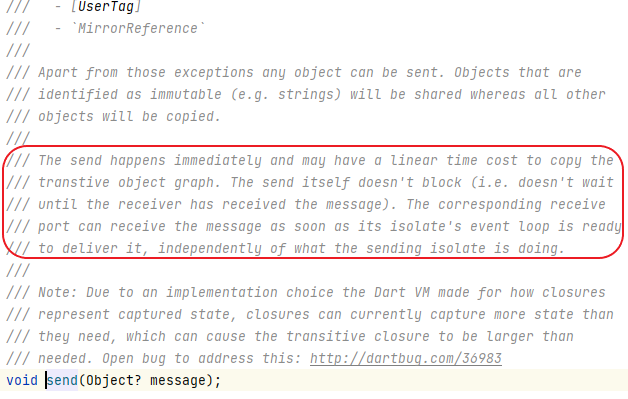

点击进入 send 方法查看源码注释,看到这样一句话:

结论:send 本身不会阻塞,会立即发送,但可能需要线性时间成本用于复制数据。

- 方式二:使用

exit

|

1 |

Isolate.exit(responsePort, data); |

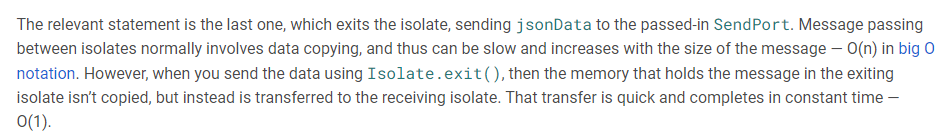

官网 给出的解释如下:

结论:隔离之间的消息传递通常涉及数据复制,因此可能会很慢,并且会随着消息大小的增加而增加。但是

exit(),则是在退出隔离中保存消息的内存,不会被复制,而是被传输到主 isolate。这种传输很快,并且在恒定的时间内完成。

我们把上面 demo 中的 _entryPoint 方法做一下优化,修改如下:

|

1 2 3 4 5 6 7 |

static void _entryPoint(SendPort port) { SendPort responsePort = args[0]; int num = args[1]; ///接收参数,进行耗时操作后返回数据 //responsePort.send(calculateEvenCount(num)); Isolate.exit(responsePort, calculateEvenCount(num)); } |

总结:使用 exit() 替代 SendPort.send,可规避数据复制,节省耗时。

isolate 组

如何创建一个 isolate 组?官方给出的解释如下:

When an isolate calls

Isolate.spawn(), the two isolates have the same executable code and are in the same isolate group. Isolate groups enable performance optimizations such as sharing code; a new isolate immediately runs the code owned by the isolate group. Also,Isolate.exit()works only when the isolates are in the same isolate group.

当在 isolate 中调用另一个 isolate 时,这两个 isolate 具有相同的可执行代码,并且位于同一隔离组。

PS: 小轰暂时也没有想到具体的使用场景,先暂放一边吧。

实践:isolate 如何处理连续数据

结合上面的耗时方法calculateEvenCount,isolate 处理连续数据需要结合 stream 流的设计。具体 demo 如下:

|

1 2 3 4 5 6 7 |

///测试入口 static testContinuityIso() async { final numbs = [10000, 20000, 30000, 40000]; await for (final data in _sendAndReceive(numbs)) { log(data.toString()); } } |

|

1 2 3 4 5 6 7 8 9 10 11 12 13 14 15 16 17 18 19 |

///具体的iso实现(主线程) static Stream<Map<String, dynamic>> _sendAndReceive(List<int> numbs) async* { final p = ReceivePort(); await Isolate.spawn(_entry, p.sendPort); final events = StreamQueue<dynamic>(p); // 拿到 子isolate传递过来的 SendPort 用于发送数据 SendPort sendPort = await events.next; for (var num in numbs) { //发送一条数据,等待一条数据结果,往复循环 sendPort.send(num); Map<String, dynamic> message = await events.next; //每次的结果通过stream流外露 yield message; } //发送 null 作为结束标识符 sendPort.send(null); await events.cancel(); } |

|

1 2 3 4 5 6 7 8 9 10 11 12 13 14 |

///具体的iso实现(子线程) static Future<void> _entry(SendPort p) async { final commandPort = ReceivePort(); //发送一个 sendPort 给主iso ,用于 主iso 发送参数给 子iso p.send(commandPort.sendPort); await for (final message in commandPort) { if (message is int) { final data = calculateEvenCount(message); p.send(data); } else if (message == null) { break; } } } |