最近网站上,被某些爬虫占用了太大的资源,导致访问不畅,网上搜了一下禁止某些爬虫的办法。

下面这些方法需要同时实施才足够稳妥。

1.在网站根目录下修改或创建.htaccess文件

|

1 2 3 4 5 6 7 8 9 10 11 12 13 14 15 16 17 18 19 20 21 22 23 24 25 26 27 28 29 30 31 32 33 34 35 36 37 38 39 |

# 禁止典型的爬虫引擎版本的访问,Chrome/FireFox 版本低于 100 的都可以认为是典型爬虫 <IfModule mod_rewrite.c> RewriteEngine On RewriteCond %{HTTP_USER_AGENT} "Chrome/[0-9]\." [NC,OR] RewriteCond %{HTTP_USER_AGENT} "Chrome/[0-9][0-9]\." [NC,OR] RewriteCond %{HTTP_USER_AGENT} "FireFox/[0-9]\." [NC,OR] RewriteCond %{HTTP_USER_AGENT} "FireFox/[0-9][0-9]\." [NC] # robots.txt 要返回,否则爬虫就以为没有robots协议了 RewriteCond %{REQUEST_FILENAME} !robots.txt RewriteRule ^(.*)$ - [F,L] </IfModule> # 禁止一搜神马搜索引擎,该搜索引擎请求数据太大,导致网站异常 <IfModule mod_rewrite.c> RewriteEngine On # 禁止一搜这个流氓爬虫 RewriteCond %{HTTP_USER_AGENT} ^YisouSpider* [NC] # robots.txt 要返回,否则爬虫就以为没有robots协议了 RewriteCond %{REQUEST_FILENAME} !robots.txt RewriteRule ^(.*)$ - [F,L] </IfModule> # 禁止 ChatGLM 搜索引擎,该搜索引擎请求数据太大,导致网站异常 <IfModule mod_rewrite.c> RewriteEngine On RewriteCond expr "%{HTTP_USER_AGENT} -strcmatch '*ChatGLM*'" # robots.txt 要返回,否则爬虫就以为没有robots协议了 RewriteCond %{REQUEST_FILENAME} !robots.txt RewriteRule ^(.*)$ - [F,L] </IfModule> # 禁止 Scrapy 搜索引擎,该爬虫不遵守 robots 协议 <IfModule mod_rewrite.c> RewriteEngine On RewriteCond expr "%{HTTP_USER_AGENT} -strcmatch '*Scrapy*'" # robots.txt 要返回,否则爬虫就以为没有robots协议了 RewriteCond %{REQUEST_FILENAME} !robots.txt RewriteRule ^(.*)$ - [F,L] </IfModule> |

注意,这个过滤条件需要添加到整个.htaccess文件的头部,否则可能由于其他的过滤条件而跳过了这个过滤条件,导致某些情况下不生效。

2.修改Apache2的配置文件

|

1 |

$ vim /etc/apache2/sites-available/000-default.conf |

禁止某些User-Agent的访问

|

1 2 3 4 5 6 7 8 9 10 |

<Directory "/var/www/wordpress"> # 禁止一搜这个流氓爬虫 SetEnvIfNoCase User-Agent ".*(YisouSpider)" denySpider # robots.txt 要放行,因此移除可能存在的条件 SetEnvIfNoCase Request_URI "robots.txt" !denySpider Order allow,deny Allow from all deny from env=denySpider </Directory> |

注意:

|

1 |

env=denySpider |

中间不可用空格,否则无法成功生效。

3.网站根目录下面增加robot.txt,禁止爬虫

|

1 2 3 |

# 一搜的爬虫访问过于频繁 User-agent: YisouSpider Disallow: / |

4.对于使用ProxyPass,ProxyPassReverse代理转发的情况

使用如下配置进行过滤

|

1 2 3 4 5 6 7 8 9 10 11 12 13 14 15 16 17 18 19 20 21 22 23 24 25 26 27 28 29 30 31 32 33 34 35 36 37 38 39 40 41 42 43 44 45 46 47 48 49 50 51 52 53 54 |

# 禁止典型的爬虫引擎版本的访问,Chrome/FireFox 版本低于 100 的都可以认为是典型爬虫 # 目前测试发现,变量声明为 badbot 似乎总是无效,貌似有其他插件/模块在使用这个变量 <Proxy "*"> SetEnvIfNoCase User-Agent "Chrome/[0-9]{1,2}\." denySpider SetEnvIfNoCase User-Agent "FireFox/[0-9]{1,2}\." denySpider Order Allow,Deny Allow from all Deny from env=denySpider </Proxy> # 禁止一搜这个流氓爬虫 <Proxy "*"> SetEnvIfNoCase User-Agent ".*(YisouSpider)" denySpider # robots.txt 要放行,因此移除可能存在的条件 SetEnvIfNoCase Request_URI "robots.txt" !denySpider Order Allow,Deny Allow from all Deny from env=denySpider </Proxy> # 禁止 ChatGLM 爬虫,此爬虫不遵守 robots 协议,且过于频繁 <Proxy "*"> SetEnvIfNoCase User-Agent ".*(ChatGLM)" denySpider # robots.txt 要放行,移除可能存在的条件 SetEnvIfNoCase Request_URI "robots.txt" !denySpider Order Allow,Deny Allow from all Deny from env=denySpider </Proxy> # 禁止 Bytespider 爬虫,此爬虫不遵守 robots 协议 <Proxy "*"> SetEnvIfNoCase User-Agent ".*(Bytespider)" denySpider # robots.txt 要放行,移除可能存在的条件 SetEnvIfNoCase Request_URI "robots.txt" !denySpider Order Allow,Deny Allow from all Deny from env=denySpider </Proxy> # 禁止 Scrapy 爬虫,此爬虫不遵守 rotots 协议 <Proxy "*"> SetEnvIfNoCase User-Agent ".*(Scrapy)" denySpider # robots.txt 要放行,移除可能存在的条件 SetEnvIfNoCase Request_URI "robots.txt" !denySpider Order Allow,Deny Allow from all Deny from env=denySpider </Proxy> |

注意:

|

1 |

env=denySpider |

中间不可用空格,否则无法成功生效。

5.验证刚刚的服务器设置是否已生效

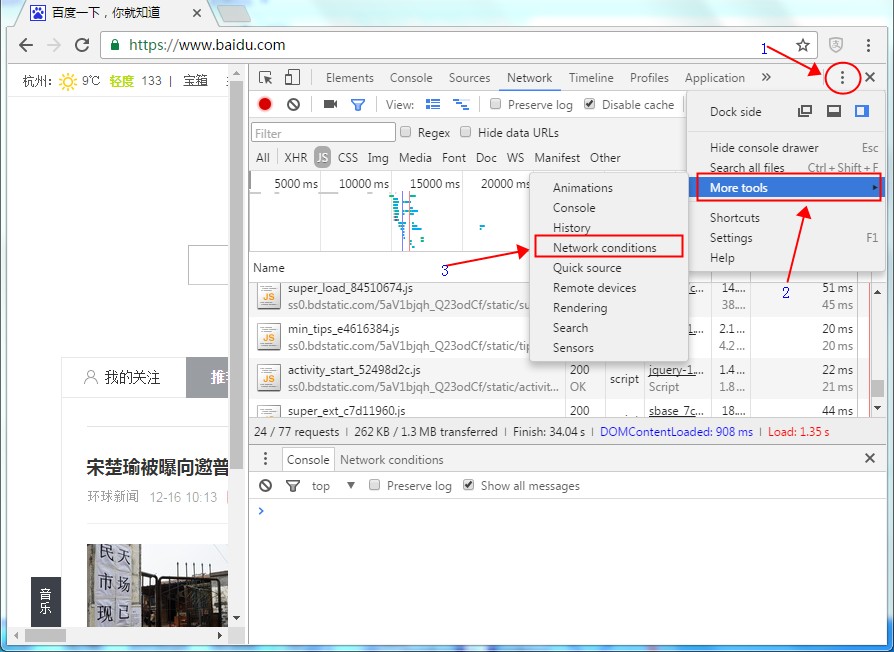

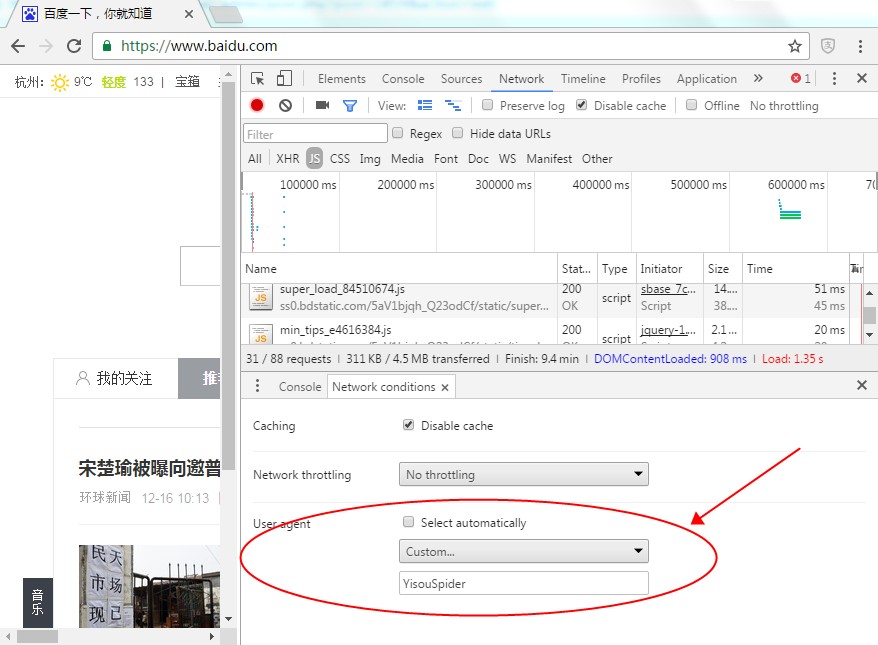

刚刚的设置完成后,我们需要修改浏览器的User Agent,来验证一下我们的设置是否已经生效了。

以Chrome-55.0为例,Windows下面按下F12,在弹出的窗口中进行如下操作:

使用命令行进行验证会更加简单,如下:

|

1 |

$ curl --user-agent "Mozilla/5.0 (compatible; ChatGLM-Spider/1.0; +https://chatglm.cn/)" "http://www.mobibrw.com/robots.txt" |